La semaine dernière, nous tentions de comprendre comment fonctionne, en simplifiant, l’intelligence artificielle. Aujourd’hui, nous allons nous pencher sur la compréhension de l’IA… et ses limites.

L’IA nous comprend… ou pas ?

La question, posée ainsi, est peut-être mal formulée. Dire que l’IA « ne comprend pas du tout » ignore sa puissance interprétative. Dire qu’elle « est intelligente » lui prête une intériorité qu’elle n’a pas.

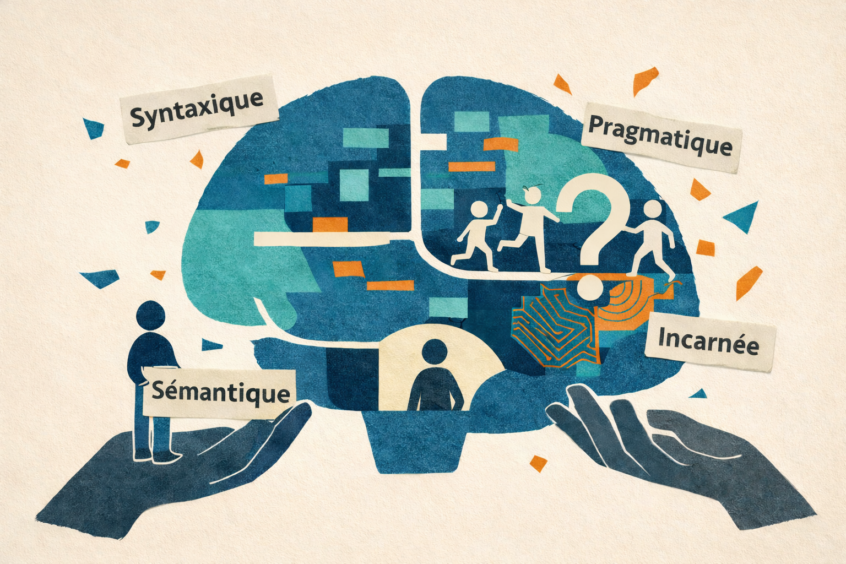

Les sciences cognitives nous ont appris que la compréhension n’est pas un bloc monolithique. Cette distinction est essentielle pour analyser finement la compréhension de l’IA :

– syntaxique : maîtriser la forme des phrases et leurs relations grammaticales.

– sémantique : relier les mots à des concepts et à du sens.

– pragmatique : interpréter le sens selon le contexte et l’intention.

– incarnée : comprendre par l’expérience vécue, sensorielle et corporelle.

Une IA générative excelle dans les premières, simule parfois la troisième avec brio, mais reste coupée de la dernière : elle ne vit pas, ne ressent pas, ne fait pas l’expérience du monde.

François Chollet, créateur du framework Keras, propose une distinction éclairante : l’intelligence cristallisée (connaissances accumulées, patterns mémorisés) versus l’intelligence fluide (adaptation à des problèmes vraiment nouveaux).

Pour tester cette dernière, il a conçu le benchmark ARC-AGI : des puzzles visuels abstraits que le système n’a jamais pu rencontrer dans ses données d’entraînement, et qui nécessitent de comprendre une règle implicite à partir de seulement quelques exemples.

C’est exactement ce qu’un enfant de 5 ans fait sans effort, mais que les IA ne parvenaient pas à faire systématiquement.

C’est le test ultime de la généralisation : non pas « as-tu mémorisé la réponse ? », mais « peux-tu résoudre un problème que personne ne t’a jamais montré ? ». Les LLM classiques excellaient sur l’intelligence cristallisée, mais échouaient sur ce test, jusqu’à récemment…

Fin 2024, le modèle o3 d’OpenAI a atteint 87% sur ARC-AGI, dépassant le seuil humain pour la première fois. Mais Chollet a immédiatement relevé la barre avec ARC-AGI-2, sur lequel les mêmes systèmes retombent à moins de 5%.

La course continue, et c’est peut-être là le point essentiel : ces systèmes progressent à une vitesse qui invalide régulièrement nos certitudes de la veille.

Les arguments d’il y a quelques années, formulés sans lecture des derniers travaux, ne tiennent souvent plus. Les débats doivent s’appuyer sur la lecture des travaux les plus récents.

L’enjeu n’est peut-être pas de savoir si elle comprend, mais comment elle fonctionne, et comment nous comprenons ce qu’elle produit.

Autrement dit, la question centrale n’est pas seulement celle de la performance, mais celle de la compréhension de l’IA dans ses différentes dimensions.

Cela dit, nuancer ne signifie pas idéaliser. Ces systèmes ont des limites bien réelles, et ce sont celles-là qu’il faut connaître pour bien les utiliser en formation.

Compréhension de l’IA : les vraies limites

Plutôt que de répéter que « l’IA est bête », examinons ses limitations réelles :

– Fragilité du raisonnement : les performances peuvent s’effondrer face à des variations mineures de formulation (même si les derniers modèles de raisonnement sont bien plus robustes).

– Hallucinations : les modèles produisent parfois des informations fausses avec une grande assurance.

– Opacité : contrairement à un programme traditionnel dont chaque étape peut être suivie, les décisions des réseaux profonds restent largement inexplicables, même pour leurs créateurs.

Cette opacité est particulièrement problématique en éducation. Si une IA évalue un élève comme « à risque de décrochage », les enseignants ont besoin de comprendre pourquoi. Sans cette compréhension, comment adapter l’accompagnement ?

À ces limites techniques s’ajoute une dimension éthique qu’on ne peut ignorer.

Compréhension de l’IA : ni perroquet, ni génie

Les LLM ne sont ni des « perroquets stochastiques » ni des intelligences générales conscientes. Ils sont quelque chose de nouveau, de complexe, qui mérite une analyse sérieuse plutôt que des raccourcis rassurants (même si ces raccourcis font de très bons posts viraux).

Ce qu’on sait avec une certitude raisonnable : ils développent des représentations internes structurées, ils exhibent des capacités de généralisation au-delà de la simple mémorisation, ils performent au niveau humain sur certaines tâches cognitives complexes, et ils ont aussi des limitations importantes et bien documentées.

Comprendre ce fonctionnement, même de manière simplifiée, permet aux formateurs de mieux appréhender les possibilités et les limites de ces outils.

Cette compréhension est essentielle pour les utiliser de manière éthique et efficace, en gardant toujours à l’esprit que l’IA doit rester un support à l’apprentissage humain, non un substitut à la relation pédagogique.

Au fond, affirmer qu’une IA est « intelligente » ou « stupide » dépend largement de la définition qu’on adopte (une définition que nous n’avons cessé de déplacer pour rester toujours un cran au-dessus).

Et à bien y réfléchir, répéter en boucle que « l’IA ne comprend rien » sans comprendre les implications ne ferait pas de nous des perroquets stochastiques ?

Illustration réalisée via Gemini