Tout a commencé un mercredi matin, alors que je vidais le verre dans la poubelle à recyclage du bahut accompagné de Sylvain (oui ma fiche de poste est assez floue chez Sydo). C’est là que l’idée de cet article m’est venue. Avec Sylvain, nous abordons souvent les différents biais des articles en sciences humaines, notamment dans le cadre de « C’est vrai ça ? » (une association de lutte contre la désinformation, notamment sur LinkedIn). Ces discussions récurrentes sur la fragilité méthodologique de tant d’études m’ont progressivement amené à questionner la valeur de ma propre thèse.

Mais au fait, pourquoi est-ce que je me livre à cette autocritique dévastatrice ? Pourquoi dynamiter volontairement ma carrière académique alors que je viens à peine d’en construire péniblement les fondations ? Me voilà transformé en kamikaze épistémologique, prêt à sacrifier mon avenir professionnel (tout du moins académique) sur l’autel de l’honnêteté intellectuelle.

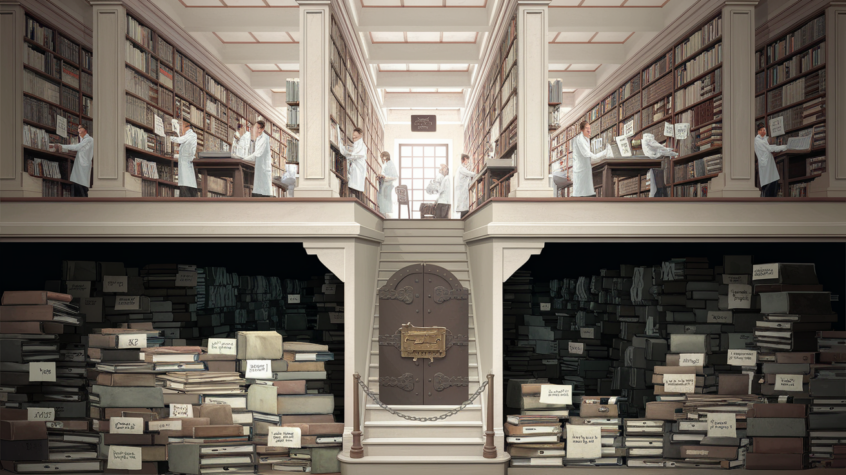

Et pourtant, j’ai passé trois ans de ma vie – les meilleures années, dit-on, mais personne ne précise jamais « les meilleures pour quoi » – enfermé dans la bibliothèque à respirer la poussière de livres que personne n’avait consultés depuis la présidence de Giscard, j’ai rempli des centaines de pages de notes, aligné des milliers de références, réalisé des expérimentations sur des centaines de personnes, et tout ça pour accoucher d’une thèse que mes propres parents n’ont pas lue au-delà de la dédicace.

Peut-être est-ce précisément là que réside ma motivation : dans ce mélange de lucidité post-traumatique et d’humour défensif qui caractérise tout rescapé du doctorat en sciences humaines.

Mais parmi tous les biais qui infestent nos recherches en sciences humaines, il y en a un qui me semble particulièrement hallucinant, et c’est sur celui-là que je vais concentrer mon attention en premier lieu. Un biais qui me fait me demander si toutes ces années passées à cultiver ma myopie dans des salles surchauffées n’étaient pas, au fond, une forme sophistiquée de procrastination existentielle : le biais de publication.

Le biais de publication : qu’est-ce que c’est ?

L’un des biais les plus pernicieux et les moins discutés publiquement est celui qui gouverne la publication même des travaux scientifiques : seules les études présentant des résultats « significatifs » sont généralement publiées. Ce phénomène, connu sous le nom de « publication bias », ou biais de publication, déforme profondément notre compréhension des phénomènes étudiés.

Imaginons un scénario concret : 100 chercheurs décident, indépendamment les uns des autres, d’étudier l’efficacité pédagogique des vidéos générées par intelligence artificielle dans l’éducation (cliquez ici pour découvrir une étude de ce type ou ici pour lire notre analyse de cette étude et ses limites). Chacun mène son étude avec rigueur, comparant les résultats d’apprentissage d’un groupe exposé à ces vidéos par rapport à un groupe témoin recevant un enseignement traditionnel.

Sur ces 100 études, disons que 95 ne trouvent aucune différence significative entre les deux méthodes. C’est-à-dire qu’ils ne montrent pas de différence de performances d’apprentissage que vous regardiez une vidéo IA ou une vidéo avec un humain. Vous pourriez me dire que c’est un résultat en soi ? Eh bien, pas du point de vue des journaux scientifiques qui ne publieront pas ces études.

Imaginons que les 5 restantes, par simple hasard statistique (le fameux seuil de significativité de p<0.05 signifie précisément qu'il existe 5% de chances d'observer un effet qui n'existe pas en réalité), trouvent un effet positif ou négatif au visionnage de vidéos IA sur l’apprentissage.

Que va-t-il se passer ? Les 5 études montrant un effet « significatif » seront publiées dans des revues scientifiques, car elles présentent un « résultat ». Les 95 autres, considérées comme « non concluantes », seront majoritairement rejetées ou même jamais soumises, leurs auteurs ayant intégré qu’une étude sans effet détectable n’intéresse pas les éditeurs.

Je vous ai perdu dans les statistiques ? Rendons cela plus concret. Imaginons que chaque étude implique 100 participants (50 dans le groupe vidéo IA et 50 dans le groupe avec des vidéos comportant un humain). Au total, ces recherches englobent donc 10 000 personnes. Sur ces 10 000 participants, seuls les 500 personnes des 5 études « significatives » verront leurs données publiées et influencer les politiques éducatives.

Les expériences des 9 500 autres participants, qui n’ont montré aucun effet particulier des vidéos IA, disparaîtront dans les tiroirs des laboratoires, comme si elles n’avaient jamais existé. Et pourtant, ces 9 500 personnes représentent 95% de l’échantillon total et reflètent probablement mieux la réalité !

Résultat : la littérature scientifique accessible contiendra principalement des études montrant un effet des vidéos IA sur l’apprentissage, alors que la réalité (invisible) est qu’aucun effet réel n’existe. Un journaliste ou un décideur politique consultant « l’état de la recherche » sur le sujet conclura que « les études scientifiques démontrent l’efficacité (ou l’inefficacité) des vidéos IA », alors que cette conclusion est radicalement (et scientifiquement) fausse.

Ce mécanisme nous amène à une conclusion fondamentale : il est généralement IMPOSSIBLE de pouvoir généraliser ou statuer sur quoi que ce soit à partir d’une seule étude, aussi rigoureuse soit-elle. Chaque étude individuelle n’est qu’un point de données dans un ensemble plus vaste, et prendre des décisions basées sur une étude isolée revient à faire un zoom excessif sur un pixel d’une image.

C’est précisément cette prise de conscience qui a conduit à la « crise de réplicabilité » (la réplicabilité est le fait d’obtenir les mêmes résultats lorsque une expérience est reproduite) qui secoue actuellement les sciences humaines et sociales.

Pour nuancer ce propos, certains domaines et protocoles expérimentaux permettent tout de même d’avancer plus solidement sur un sujet. Les neurosciences, par exemple, avec leurs protocoles standardisés et leurs mesures physiques directes, peuvent produire des résultats plus fiables et reproductibles que les études purement comportementales ou déclaratives.

Quelle solution face au biais de publication ?

Face à cette limitation structurelle, les méta-analyses (analyses statistiques combinant les résultats de multiples études indépendantes) sont devenues essentielles. Elles permettent théoriquement de contrebalancer ce biais de publication en offrant une vue d’ensemble plus fidèle à la réalité.

Mais même ces méta-analyses se heurtent à un problème fondamental : elles ne peuvent inclure que les études publiées, perpétuant ainsi le biais initial si les études aux résultats « négatifs » ou « non-significatifs » restent dans les tiroirs. Ce phénomène est connu sous le nom de « file drawer problem » (problème du tiroir) et continue de compromettre notre capacité à établir des connaissances fiables en sciences humaines.

Une autre solution prometteuse émerge progressivement : le système des « preprints » (pré-publications). Ces plateformes comme PsyArXiv, SocArXiv ou OSF Preprints permettent aux chercheurs de partager librement leurs résultats avant ou indépendamment du processus d’évaluation par les pairs traditionnel. Ainsi, une étude ne montrant pas d’effet significatif peut néanmoins être rendue publique et contribuer à la connaissance collective.

Plus prometteur encore, certaines revues scientifiques commencent à proposer des « Registered Reports » : le protocole de recherche est évalué et accepté avant que l’étude ne soit menée, et la revue s’engage à publier les résultats quelle que soit leur significativité statistique. Cette approche inverse la logique perverse du système actuel en évaluant la qualité méthodologique plutôt que le caractère « vendeur » des résultats.

D’autres initiatives encourageantes se développent pour valoriser les résultats « négatifs » ou « non significatifs ». Ainsi, le Global Preclinical Data Forum organise un prix des résultats négatifs, récompensant les chercheurs qui publient des études rigoureuses n’ayant pas abouti aux effets escomptés. Des revues spécialisées comme le Journal of Negative Results ont été créées spécifiquement pour accueillir ces travaux essentiels mais traditionnellement négligés.

L’impératif de l’esprit critique

En attendant que ces pratiques se généralisent, il nous reste une ressource précieuse : l’esprit critique. Face à tout article scientifique, particulièrement en sciences humaines, une posture de scepticisme méthodique s’impose.

À chaque fois que vous lisez une étude aux résultats significatifs et aux conclusions enthousiastes, gardez à l’esprit qu’il existe probablement, quelque part, 95 autres chercheurs ou doctorants qui pleurent silencieusement dans leur laboratoire. Ils ont mené la même étude, avec autant de rigueur, mais n’ont obtenu aucun résultat « publiable ». Leurs données, tout aussi valides, disparaîtront dans les méandres des disques durs universitaires.

Un autre aspect crucial à considérer est la nature fondamentalement multifactorielle des phénomènes étudiés en sciences humaines et particulièrement en éducation. Reprenons notre exemple des vidéos IA dans l’éducation. Le chercheur s’efforcera d’isoler au maximum les variables : même niveau scolaire, même âge, même sujet d’étude, même durée d’exposition… Mais cette maîtrise reste une illusion.

Est-on certain que tous les participants ont le même attrait pour le sujet étudié ? Certainement pas. Que dire de leur familiarité ou appétence préalable pour les technologies numériques ? De leurs capacités attentionnelles individuelles ? De leur état de fatigue le jour de l’expérience ? De la qualité de leur petit-déjeuner ? Du fait qu’ils se sont disputés ou non avec leur partenaire la veille ? Tous ces facteurs, impossibles à contrôler exhaustivement, peuvent influencer les résultats autant sinon plus que la variable supposément isolée.

Cette réalité multifactorielle est particulièrement problématique quand les effets mesurés sont subtils – ce qui est généralement le cas en sciences humaines. Si l’effet d’une intervention pédagogique n’améliore théoriquement les performances que de 5%, mais que la variabilité due à la motivation de base des participants peut faire osciller ces mêmes performances de ±15%, comment distinguer l’impact de notre intervention ?

Le chercheur peut bien augmenter la taille de son échantillon pour atténuer ces variations individuelles, mais il se heurte rapidement à des contraintes pratiques et financières. Et même avec un échantillon conséquent, la généralisation reste problématique : ce qui fonctionne avec des étudiants volontaires de première année de psychologie d’une université parisienne est-il valable pour d’autres populations, dans d’autres contextes ?

Le biais de publication : conclusion

Et bien, voilà, mon autocritique se termine. Dans le cadre de ma thèse, je n’ai évidemment pas pu échapper à ces biais : il serait par exemple nécessaire au moins de répliquer mes expérimentations.

Et cette autocritique n’a abordé que certaines problématiques – je ne suis pas fou au point de vous décrire tous les biais existants dans le domaine des sciences humaines. J’aurais pu continuer et parler des biais de financement, des pressions idéologiques, des effets de mode théoriques, des conflits d’intérêts, de l’ethnocentrisme occidental… La liste est longue et pourrait faire l’objet d’une autre thèse (qui elle-même souffrirait probablement des mêmes biais).

Alors, est-ce que ma thèse ne vaut rien ? Et bien non, il faut juste la voir telle qu’elle est : une première étape d’une réflexion nécessitant réplicabilité. Une pièce modeste dans un puzzle scientifique bien plus vaste, un point de données parmi d’autres, une contribution limitée mais nécessaire à l’édifice collectif de la connaissance.

En définitive, ma thèse vaut exactement ce que vaut toute entreprise scientifique honnête : une tentative imparfaite mais sincère de comprendre un petit fragment du monde, dans l’espoir que d’autres poursuivront, nuanceront et approfondiront ce travail. Et c’est déjà beaucoup.

Pour aller plus loin

– https://web.ma.utexas.edu/users/mks/statmistakes/filedrawer.html

– https://bbf.enssib.fr/matieres-a-penser/les-oubliettes-de-la-recherche-ou-l-effet-tiroir-file-drawer-effect-faire-passer-les-resultats-negatifs-de-l-ombre-a-la-lumiere_70065

– https://www.sciencedirect.com/science/article/pii/S0360131524001787?via%3Dihub

Article scientifique, Biais de publication, expérience, sciences, Sciences humaines, Thèse

Un commentaire

On peut aussi indiquer l’utilisation d’autres types de statistiques qui, plutôt que de soit conclure en la présence d’une différence ou ne pas pouvoir conclure du tout (p-value), peuvent permettre de conclure en la présence d’une différence, en son absence, ou ne pas conclure ni en la présence ni en l’absence (comparaison de modèles). Car c’est bien l’un des problèmes : Lorsqu’il n’y a pas de différences significatives, on ne peut rien en conclure du tout. Dire que cela signifie qu’il n’y a pas de différence est une erreur.